Debemos reconocer que la pandemia del Covid-19 está teniendo consecuencias que afectan a nuestra vida, nuestro trabajo, el mundo de la enseñanza, la cultura, el ocio, etc… En fin, afecta el día a día en que normalmente nos movemos. Tenemos que saber que Covid-19 es el nombre oficial que la OMS le dio en febrero de 2020 a la enfermedad infecciosa causada por el nuevo coronavirus, es decir por el virus SARS-CoV-2. Esta pandemia también está afectando a muchas personas, pequeños empresarios, autónomos, trabajadores e inmigrantes sin papeles, que han perdido su trabajo y, en muchos casos, sus ingresos. Por ello es tan importante encontrar soluciones farmacológicas que puedan paliar los efectos del virus. Distintos equipos investigadores están intentando  obtener cuanto antes antivirales para inhibir los contagios, mientras a más largo plazo se está tratando de encontrar una vacuna efectiva contra el virus. Hoy en día hay necesidad de adoptar un enfoque riguroso, multidisciplinar y coherente con la respuesta que den los distintos países y las instancias mundiales, como la OMS. En este artículo me centraré en los avances de la Inteligencia Artificial (IA) para encontrar soluciones más rápidas, potentes y efectivas para combatir a bacterias, que se han hecho resistentes a los actuales antibióticos, y virus, que puedan terminar siendo pandemias, así como otro tipo de enfermedades, como el cáncer. Ello es aún más importante cuanto tenemos miles de distintas bacterias y virus, así como múltiples otras enfermedades que pueden atacar a los seres humanos. El 12 de marzo de 2020, Will Douglas Heaven, de MIT News, explicó que se cree que la Inteligencia Artificial (IA) podría ayudar con la próxima pandemia, pero ya no con esta actual pandemia del Covid-19. Algunas cosas deben cambiar si queremos que la IA sea útil la próxima vez y, según Heaven, es posible que algunas no nos gusten. Fue un algoritmo de IA el que vio venir la pandemia por primera vez, o eso dice la historia. En efecto, el 30 de diciembre de 2019, una compañía de inteligencia artificial llamada BlueDot, que utiliza el aprendizaje automático para monitorear brotes de enfermedades infecciosas en todo el mundo, alertó a sus clientes, incluidos varios gobiernos, hospitales y empresas, sobre un aumento inusual en los casos de neumonía en Wuhan, China, que presagiaban alguna posible epidemia. Pero pasarían otros nueve días antes de que la Organización Mundial de la Salud (OMS) señalara oficialmente lo que todos conocemos como Covid-19. Ello demostró que la IA es capaz de detectar con gran rapidez y eficacia lo que los humanos tenemos mucha más dificultad de hacerlo.

obtener cuanto antes antivirales para inhibir los contagios, mientras a más largo plazo se está tratando de encontrar una vacuna efectiva contra el virus. Hoy en día hay necesidad de adoptar un enfoque riguroso, multidisciplinar y coherente con la respuesta que den los distintos países y las instancias mundiales, como la OMS. En este artículo me centraré en los avances de la Inteligencia Artificial (IA) para encontrar soluciones más rápidas, potentes y efectivas para combatir a bacterias, que se han hecho resistentes a los actuales antibióticos, y virus, que puedan terminar siendo pandemias, así como otro tipo de enfermedades, como el cáncer. Ello es aún más importante cuanto tenemos miles de distintas bacterias y virus, así como múltiples otras enfermedades que pueden atacar a los seres humanos. El 12 de marzo de 2020, Will Douglas Heaven, de MIT News, explicó que se cree que la Inteligencia Artificial (IA) podría ayudar con la próxima pandemia, pero ya no con esta actual pandemia del Covid-19. Algunas cosas deben cambiar si queremos que la IA sea útil la próxima vez y, según Heaven, es posible que algunas no nos gusten. Fue un algoritmo de IA el que vio venir la pandemia por primera vez, o eso dice la historia. En efecto, el 30 de diciembre de 2019, una compañía de inteligencia artificial llamada BlueDot, que utiliza el aprendizaje automático para monitorear brotes de enfermedades infecciosas en todo el mundo, alertó a sus clientes, incluidos varios gobiernos, hospitales y empresas, sobre un aumento inusual en los casos de neumonía en Wuhan, China, que presagiaban alguna posible epidemia. Pero pasarían otros nueve días antes de que la Organización Mundial de la Salud (OMS) señalara oficialmente lo que todos conocemos como Covid-19. Ello demostró que la IA es capaz de detectar con gran rapidez y eficacia lo que los humanos tenemos mucha más dificultad de hacerlo.

obtener cuanto antes antivirales para inhibir los contagios, mientras a más largo plazo se está tratando de encontrar una vacuna efectiva contra el virus. Hoy en día hay necesidad de adoptar un enfoque riguroso, multidisciplinar y coherente con la respuesta que den los distintos países y las instancias mundiales, como la OMS. En este artículo me centraré en los avances de la Inteligencia Artificial (IA) para encontrar soluciones más rápidas, potentes y efectivas para combatir a bacterias, que se han hecho resistentes a los actuales antibióticos, y virus, que puedan terminar siendo pandemias, así como otro tipo de enfermedades, como el cáncer. Ello es aún más importante cuanto tenemos miles de distintas bacterias y virus, así como múltiples otras enfermedades que pueden atacar a los seres humanos. El 12 de marzo de 2020, Will Douglas Heaven, de MIT News, explicó que se cree que la Inteligencia Artificial (IA) podría ayudar con la próxima pandemia, pero ya no con esta actual pandemia del Covid-19. Algunas cosas deben cambiar si queremos que la IA sea útil la próxima vez y, según Heaven, es posible que algunas no nos gusten. Fue un algoritmo de IA el que vio venir la pandemia por primera vez, o eso dice la historia. En efecto, el 30 de diciembre de 2019, una compañía de inteligencia artificial llamada BlueDot, que utiliza el aprendizaje automático para monitorear brotes de enfermedades infecciosas en todo el mundo, alertó a sus clientes, incluidos varios gobiernos, hospitales y empresas, sobre un aumento inusual en los casos de neumonía en Wuhan, China, que presagiaban alguna posible epidemia. Pero pasarían otros nueve días antes de que la Organización Mundial de la Salud (OMS) señalara oficialmente lo que todos conocemos como Covid-19. Ello demostró que la IA es capaz de detectar con gran rapidez y eficacia lo que los humanos tenemos mucha más dificultad de hacerlo.

obtener cuanto antes antivirales para inhibir los contagios, mientras a más largo plazo se está tratando de encontrar una vacuna efectiva contra el virus. Hoy en día hay necesidad de adoptar un enfoque riguroso, multidisciplinar y coherente con la respuesta que den los distintos países y las instancias mundiales, como la OMS. En este artículo me centraré en los avances de la Inteligencia Artificial (IA) para encontrar soluciones más rápidas, potentes y efectivas para combatir a bacterias, que se han hecho resistentes a los actuales antibióticos, y virus, que puedan terminar siendo pandemias, así como otro tipo de enfermedades, como el cáncer. Ello es aún más importante cuanto tenemos miles de distintas bacterias y virus, así como múltiples otras enfermedades que pueden atacar a los seres humanos. El 12 de marzo de 2020, Will Douglas Heaven, de MIT News, explicó que se cree que la Inteligencia Artificial (IA) podría ayudar con la próxima pandemia, pero ya no con esta actual pandemia del Covid-19. Algunas cosas deben cambiar si queremos que la IA sea útil la próxima vez y, según Heaven, es posible que algunas no nos gusten. Fue un algoritmo de IA el que vio venir la pandemia por primera vez, o eso dice la historia. En efecto, el 30 de diciembre de 2019, una compañía de inteligencia artificial llamada BlueDot, que utiliza el aprendizaje automático para monitorear brotes de enfermedades infecciosas en todo el mundo, alertó a sus clientes, incluidos varios gobiernos, hospitales y empresas, sobre un aumento inusual en los casos de neumonía en Wuhan, China, que presagiaban alguna posible epidemia. Pero pasarían otros nueve días antes de que la Organización Mundial de la Salud (OMS) señalara oficialmente lo que todos conocemos como Covid-19. Ello demostró que la IA es capaz de detectar con gran rapidez y eficacia lo que los humanos tenemos mucha más dificultad de hacerlo.

Pero la empresa BlueDot no estaba sola. Un servicio automatizado llamado HealthMap, en el Boston Children’s Hospital, también detectó esos primeros signos. Al igual que un modelo dirigido por Metabiota, con sede en San Francisco, una empresa de análisis de riesgos que busca dificultar que las enfermedades infecciosas representen amenazas económicas para las empresas y los gobiernos. Pero que un algoritmo de IA pueda detectar un brote en el otro lado del mundo es bastante sorprendente, y ya sabemos que las advertencias tempranas salvan vidas. Pero, ¿cuánto ha ayudado realmente la IA para abordar el brote actual? Esta es una pregunta difícil de responder. Las empresas como BlueDot suelen tener dudas acerca de a quién proporcionan la información y de cómo se utiliza. Y algunos equipos científicos humanos afirman que detectaron el brote el mismo día que las IA. Otros proyectos en los que la IA se está explorando como una herramienta de diagnóstico o para ayudar a encontrar una vacuna todavía están en sus etapas iniciales. Incluso si tienen éxito, llevará tiempo, posiblemente meses, poner esas innovaciones en manos de los expertos de la salud que las necesiten. De hecho, la narrativa de que la IA es una nueva arma poderosa contra las enfermedades es solo en parte cierta y corre el riesgo de volverse contraproducente. Por ejemplo, demasiada confianza en las capacidades de AI podría conducir a decisiones poco informadas, que canalizasen dinero público a compañías de IA no probadas en lugar de intervenciones comprobadas, como programas en drogas farmacológicas. También las expectativas exageradas pero decepcionantes han provocado una disminución en el interés en la IA y la consiguiente pérdida de fondos. Así que aquí tenemos una comprobación de la realidad. Esta vez la IA no nos salvará del coronavirus. Pero hay muchas posibilidades de que juegue un papel más importante en futuras epidemias, si hacemos algunos cambios importantes. La mayoría de estos cambios no serán fáciles y, probablemente, no nos gustarán. Hay tres áreas principales en las que la IA podría ayudar: la predicción, el diagnóstico y el tratamiento. En el campo de la predicción tenemos empresas, como BlueDot y Metabiota, que utilizan una variedad de algoritmos de procesamiento en lenguaje natural para monitorizar los medios de comunicación e informes oficiales de atención médica, en diferentes idiomas y en todo el mundo. A partir de esta monitorización pueden señalar si mencionan enfermedades de alta prioridad, como el coronavirus u otras epidemias, como el VIH o la tuberculosis. Sus herramientas predictivas también pueden recurrir a datos de viajes aéreos para evaluar el riesgo de que los centros de tránsito puedan ver a personas infectadas llegando o saliendo de distintas zonas. Los resultados actuales son razonablemente precisos. Por ejemplo, un reciente informe público de Metabiota, el 25 de febrero de 2020, predijo que el 3 de marzo de 2020 habría 127.000 casos acumulativos en todo el mundo. Excedió en alrededor de 30.000, pero Mark Gallivan, director de ciencia de los datos de la empresa, dice que esto todavía está dentro del margen de error. También enumeró los países con mayor probabilidad de reportar nuevos casos, incluidos China, Italia, Irán y los Estados Unidos. De nuevo, acertaron bastante.

Otros algoritmos también vigilan las redes sociales. Stratifyd, una compañía de análisis de datos con sede en Charlotte, Carolina del Norte, está desarrollando una IA que escanea publicaciones en sitios como Facebook y Twitter y hace referencias cruzadas con descripciones de enfermedades tomadas de fuentes como los Institutos Nacionales de Salud, la Organización Mundial para Animal Health, y la base de datos global de identificadores microbianos, que almacena información de secuenciación del genoma. El trabajo de estas empresas muestra hasta qué punto el aprendizaje automático ha avanzado en los últimos años. Hace unos años, Google intentó predecir brotes con su desafortunado Flu Tracker, que se archivó en 2013 cuando no pudo predecir el pico de gripe de ese año. ¿Qué ha cambiado desde entonces? Se trata principalmente de la capacidad del último software para acceder una gama mucho más amplia de fuentes. El aprendizaje automático no supervisado también es clave. Permitir que una IA identifique sus propios patrones en la información que va detectando, en lugar de entrenarla en ejemplos preseleccionados, resalta hechos que quizás no se haya pensado buscar previamente. “Cuando haces predicciones, estás buscando un nuevo comportamiento“, dice el CEO de Stratifyd, Derek Wang. ¿Pero qué se hace con estas predicciones? La predicción inicial de BlueDot identificó correctamente un puñado de ciudades a las que se dirigía el virus. Esto podría haber permitido a las autoridades prepararse, alertar a los hospitales y establecer medidas de contención en una fase inicial. Pero a medida que crece el escalado de la epidemia, las predicciones se vuelven menos específicas. La advertencia de Metabiota de que ciertos países se verían afectados durante la semana siguiente podría haber sido correcta, pero es difícil saber qué hacer con esa información. Además, todos estos enfoques serán menos precisos a medida que progrese la epidemia, en gran parte porque los datos confiables del tipo de los que la IA necesita alimentarse han sido difíciles de obtener sobre Covid-19. Los noticiarios e informes oficiales ofrecen cuentas de infecciones y muertes bastante inconsistentes. También ha habido confusión sobre los síntomas y la forma en que el virus se transmite entre las personas. Los medios de comunicación pueden especular, mientras que las autoridades pueden minimizar el problema. Y predecir dónde se puede propagar una enfermedad desde cientos de lugares en docenas de países es una tarea mucho más desalentadora que avisar sobre dónde podría propagarse un brote en sus primeros días. “El ruido siempre es enemigo de los algoritmos de aprendizaje automático“, dice Derek Wang.

De hecho, Mark Gallivan reconoce que las predicciones diarias de Metabiota fueron más fáciles de hacer en las primeras dos semanas, más o menos. Uno de los mayores obstáculos es la falta de pruebas de diagnóstico, dice Gallivan. “Idealmente, tendríamos una prueba para detectar el nuevo coronavirus de inmediato y evaluar a todos al menos una vez al día“, dice. Tampoco sabemos realmente qué comportamientos están adoptando las personas, como quién trabaja desde casa, quién se pone en cuarentena, quién se lava las manos o no, o qué efecto podría tener. Si se desea predecir lo que sucederá a continuación, se necesita una imagen precisa de lo que está sucediendo en este momento. Tampoco está claro qué sucede dentro de los hospitales. Ahmer Inam, responsable de analítica avanzada en Pactera Edge, una consultora de datos e inteligencia artificial, dice que las herramientas de predicción serían mucho mejores si los datos de salud pública no estuvieran recluidos dentro de las agencias gubernamentales, como lo están en muchos países, incluido Estados Unidos. Esto significa que un algoritmo de IA debe apoyarse más en los datos fácilmente disponibles, como las noticias en línea. “Para cuando los medios de comunicación se den cuenta de una condición médica potencialmente nueva, ya es demasiado tarde“, dice Ahmer Inam. Pero si los algoritmos de IA necesita muchos más datos de fuentes confiables para ser útiles en esta área, las estrategias para obtenerla pueden ser controvertidas. Desgraciadamente para obtener mejores predicciones del aprendizaje automático, se necesitan compartir más datos personales con empresas y gobiernos, lo que implica menor privacidad de datos esenciales, como los médicos. Darren Schulte, CEO de Apixio, que ha creado una IA para extraer información de los registros de pacientes, cree que los registros médicos de todo Estados Unidos deberían abrirse para el análisis de datos. Esto podría permitir que una IA identifique automáticamente a las personas con mayor riesgo de Covid-19 debido a una afección subyacente. Los recursos podrían centrarse en aquellas personas que más los necesitan. La tecnología para leer registros de pacientes y extraer información que salva vidas existe, dice Schulte. El problema es que estos registros se dividen en múltiples bases de datos y son administrados por diferentes servicios de salud, lo que los hace más difíciles de analizar. “Me gustaría colocar mi IA en este gran océano de datos“, dice Schulte. “Pero nuestros datos se encuentran en pequeños lagos, no en un gran océano“.

Los datos de salud también deben compartirse entre los países, dice Ahmer Inam: “Los virus no operan dentro de los límites de las fronteras geopolíticas“. Cree que los países deberían verse obligados por acuerdo internacional a publicar datos en tiempo real sobre diagnósticos y admisiones hospitalarias, que luego podrían incorporarse a modelos del estudio de pandemia mediante aprendizaje automático a escala global. Por supuesto, esto puede ser complicado, ya que en diferentes partes del mundo tienen diferentes regulaciones de privacidad para los datos médicos. Y muchos de nosotros no queremos que nuestros datos médicos sean accesibles a terceros. Las nuevas técnicas de procesamiento de datos, como la privacidad diferencial y la capacitación sobre datos sintéticos en lugar de datos reales, podrían ofrecer una solución a este espinoso tema. La privacidad diferencial es un sistema para compartir públicamente información sobre un conjunto de datos al describir los patrones de los grupos dentro del conjunto de datos mientras se retiene información sobre las personas en el conjunto de datos. Otra forma de describir la privacidad diferencial es como una restricción en los algoritmos utilizados para publicar información agregada sobre una base de datos estadística que limita la divulgación de información privada de registros cuya información está en la base de datos. Por ejemplo, algunas agencias gubernamentales utilizan algoritmos diferencialmente privados para publicar información demográfica u otros agregados estadísticos al tiempo que garantizan la confidencialidad de las respuestas de las encuestas, y las compañías recopilan información sobre el comportamiento del usuario mientras controlan lo que es visible incluso para los analistas internos. Los datos sintéticos son la clave para hacer que el aprendizaje automático de la Inteligencia Artificial sea más rápido, y que se adopten algoritmos de la IA en nuestro día a día. Muchos expertos creen que los datos sintéticos son la clave para hacer que el aprendizaje automático de la Inteligencia Artificial sea más rápido y que se adopten algoritmos de la IA en nuestro día a día. Los datos sintéticos son datos artificiales fabricados por ordenadores, que los recopila de situaciones del mundo real. Estos datos son anónimos, y se crean con parámetros de cada usuario para que estos se asemejen al mundo real. Por ejemplo, se pueden crear datos sintéticos con los datos reales pero sin utilizar nombres, correos electrónicos, números de seguridad social o direcciones de esos datos. Los modelos generativos pueden aprender datos reales así como crear datos que sean parecidos a estos.

Estos datos sintéticos tienen muchas utilidades, entre ellas minimizar el tiempo, el coste y el riesgo de las operaciones. Los datos sintéticos tienen un gran potencial para las máquinas de aprendizaje profundo y los algoritmos de IA. Google, Amazon y Facebook tienen una ventaja considerable gracias a la cantidad de datos que crean a diario. Y es que la creación de datos sintéticos es más rentable que la recopilación de datos del mundo real la mayoría de las veces, y además algunas investigaciones evidencian que es posible obtener los mismos resultados utilizando datos sintéticos que datos de la realidad. El problema de los datos sintéticos es que es difícil crear datos de gran calidad. Si estos datos no son muy parecidos a los datos reales, se perderá calidad. Como son réplicas de propiedades específicas de un conjunto de datos reales, algunos comportamientos aleatorios pueden pasar desapercibidos. Los datos sintéticos pueden servir a nivel de registro para organizaciones médicas, para informar sobre los protocolos de atención y que la privacidad de los datos del paciente sea esencial. Pero esta tecnología aún se está perfeccionando. Encontrar un acuerdo sobre las normas internacionales llevará aún más tiempo. Por ahora, debemos aprovechar al máximo los datos que tenemos. La respuesta de Wang es asegurarse de que los humanos estén cerca para interpretar lo que los modelos de aprendizaje automático producen, asegurándose de descartar las predicciones que no suenan verdaderas. “Si uno es demasiado optimista o depende de un modelo predictivo totalmente autónomo, resultará problemático“, dice Wang. Las IA pueden encontrar señales ocultas en los datos, pero los humanos aún deben establecer relaciones. A fin de poder llevar a cabo un diagnostico temprano, además de predecir el curso de una epidemia, muchos esperan que la IA ayude a identificar a las personas infectadas. La IA tiene un historial se éxitos en este campo. Los modelos de aprendizaje automático para examinar imágenes médicas pueden detectar signos tempranos de enfermedades que los médicos humanos pasan por alto, desde enfermedades oculares hasta afecciones cardíacas o cáncer. Pero estos modelos generalmente requieren muchos datos para aprender. Se sugiere que el aprendizaje automático puede diagnosticar Covid-19 a partir de tomografías computarizadas de tejido pulmonar, si está capacitado para detectar signos reveladores de la enfermedad en las imágenes.

Alexander Selvikvåg Lundervold, de la Universidad de Ciencias Aplicadas de Noruega Occidental, en Bergen, Noruega, experto en aprendizaje automático e imágenes médicas, dice que debemos esperar que la IA pueda detectar eventualmente signos de Covid-19 en pacientes. Pero no está claro si la imagen es el camino a seguir. Por un lado, los signos físicos de la enfermedad pueden no aparecer en las exploraciones hasta algún tiempo después de la infección, por lo que no es muy útil como diagnóstico temprano. Además, dado que hasta el momento se dispone de muy pocos datos de capacitación, es difícil evaluar la precisión de los enfoques publicados en línea. La mayoría de los sistemas de reconocimiento de imágenes, incluidos los capacitados en imágenes médicas, están adaptados de los primeros modelos capacitados en ImageNet, un conjunto de datos ampliamente utilizado que abarca millones de imágenes cotidianas. “Para clasificar algo simple que está cerca de los datos de ImageNet, como las imágenes de perros y gatos, se puede hacer con muy poca información, pero hallazgos sutiles en imágenes médicas, no tanto“, dice Lundervold. Eso no quiere decir que no sucederá relativamente pronto y las herramientas de IA podrían construirse potencialmente para detectar las primeras etapas de la enfermedad en brotes futuros. Pero deberíamos ser escépticos sobre muchas de las afirmaciones de los médicos expertos en IA que diagnostican Covid-19 actualmente. Nuevamente, compartir más datos del paciente ayudará, y también lo harán las técnicas de aprendizaje automático que permiten entrenar modelos, incluso cuando hay pocos datos disponibles. Por ejemplo, el aprendizaje a partir de pocos datos, donde una IA puede aprender patrones de solo unos pocos resultados, y el aprendizaje de transferencia, donde una IA ya entrenada para hacer una cosa puede adaptarse rápidamente para hacer algo similar, son avances prometedores, pero aún está en fase experimental. Los datos también son esenciales para que la IA ayude a desarrollar tratamientos para la enfermedad. Una técnica para identificar posibles candidatos a fármacos es utilizar algoritmos de diseño generativo, que producen una gran cantidad de resultados potenciales y permite luego examinarlos para resaltar aquellos que vale la pena observar más de cerca.

Esta técnica se puede utilizar para buscar rápidamente a través de millones de estructuras biológicas o moleculares. Por ejemplo. SRI International está colaborando en el desarrollo de una herramienta de IA de este tipo, que utiliza el aprendizaje profundo para generar muchos nuevos fármacos candidatos que los científicos pueden evaluar para determinar su eficacia. Esto cambia las reglas del juego para el descubrimiento de drogas farmacológicas, pero aún pueden pasar muchos meses antes de que un candidato prometedor se convierta en un tratamiento viable. En teoría, las IA también podrían usarse para predecir la evolución del Covid-19. Ahmer Inam imagina ejecutar algoritmos de aprendizaje sin supervisión para simular todas las posibles rutas de evolución. Luego, podría agregar posibles vacunas a la mezcla y ver si los virus mutan para desarrollar resistencia. “Esto permitirá a los virólogos estar unos pasos por delante de los virus y crear vacunas en caso de que ocurra alguna de estas mutaciones del fin del mundo“, dice Inam. Es una posibilidad interesante, pero aún remota. Todavía no tenemos suficiente información sobre cómo muta el virus para poder simularlo. Mientras tanto, la barrera final pueden ser las autoridades políticas que gestionan una epidemia. “Lo que más me gustaría cambiar es la relación entre los encargados de formular políticas y la IA. La IA no podrá predecir brotes de enfermedades por sí misma, sin importar la cantidad de datos que obtenga. Hacer que los líderes del gobierno, las empresas y la atención médica confíen en estas herramientas cambiará fundamentalmente la rapidez con la que podemos reaccionar ante los brotes de enfermedades“, dice Wang. Pero esa confianza debe provenir de una visión realista de lo que la IA puede y no puede hacer ahora, así como lo que podría mejorar la próxima vez. Aprovechar al máximo la IA requerirá muchos datos, tiempo y coordinación inteligente entre muchas personas diferentes.

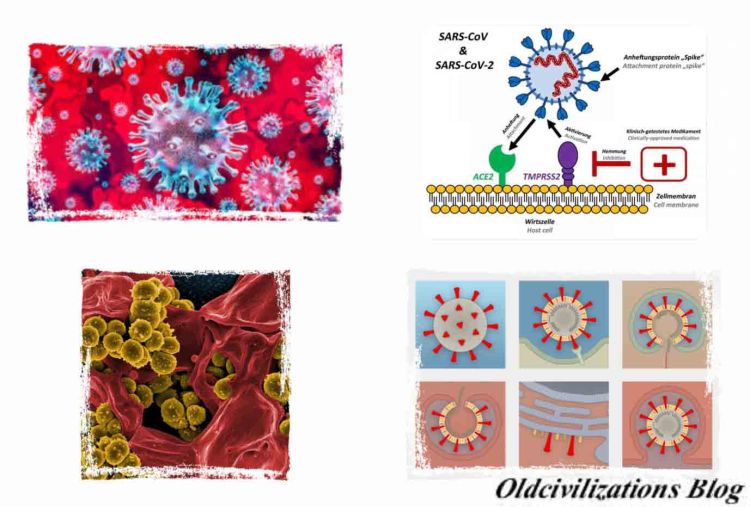

Pero antes de seguir con la IA intentemos saber algo más sobre este virus. Al igual que cuando se determinó, en los años ochenta del siglo XX, que el virus de la inmunodeficiencia humana VIH, que causa el sida, no había sido producido en ningún laboratorio, ahora un equipo multinacional de científicos llega a la conclusión de que el coronavirus SARS-CoV-2, que causa el Covid-19, tuvo su origen en la ciudad china de Wuhan, a finales del año pasado, producto de una evolución natural. En el análisis de los datos públicos de la secuencia del genoma del SARS-CoV-2 y los virus relacionados, los investigadores no encontraron evidencia de que el coronavirus se haya producido en un laboratorio o haya sido diseñado de otro modo, como se detalla en Nature Medicine. Ahora, como señala Kristian Andersen, del Centro de Investigación Biomédico Scripps Research y miembro del equipo que ha llevado a cabo el estudio, “al comparar los datos disponibles de la secuencia del genoma para las cepas conocidas de coronavirus, podemos determinar firmemente que el SARS-CoV-2 se originó a través de procesos naturales”. Además de Kristian Andersen, este equipo estuvo integrado por otros investigadores como Robert F. Garry, de la Universidad de Tulane, Edward Holmes, de la Universidad de Sydney, Andrew Rambaut, de la Universidad de Edimburgo, y W. Ian Lipkin, de la Universidad de Columbia. Los coronavirus son una gran familia de virus que pueden causar enfermedades que varían ampliamente en su nivel de severidad. La primera enfermedad grave conocida causada por un coronavirus surgió con la epidemia del Síndrome Respiratorio Agudo Severo (SRAS) de 2003, también en China. Un segundo brote de enfermedad grave comenzó en 2012, en Arabia Saudita, con el Síndrome Respiratorio del Medio Oriente (MERS). El 31 de diciembre del 2019, las autoridades chinas alertaron a la Organización Mundial de la Salud (OMS) del brote de una nueva cepa de coronavirus que causa una enfermedad grave y muy contagiosa, que posteriormente se denominó SARS-CoV-2. Poco después de que comenzara la epidemia, científicos chinos secuenciaron el genoma del SARS-CoV-2 y pusieron los datos a disposición de investigadores de todo el mundo. De todos modos, en cada país tienen que realizarse nuevas secuenciaciones para determinar posibles mutaciones del virus. Los datos de la secuencia genómica resultante han demostrado que las autoridades chinas detectaron rápidamente la epidemia y que el número de casos de COVID-19 ha aumentado debido a la transmisión de persona a persona después de una sola introducción en la población humana. Andersen y su equipo multinacional y multidisciplinar utilizaron estos datos de secuenciación para explorar los orígenes y la evolución del SARS-CoV-2, centrándose en varias características reveladoras del virus.

Así, los científicos analizaron la plantilla génica para las proteínas espiga, una especie de armaduras en el exterior del virus que utiliza para atrapar y penetrar las paredes externas de las células humanas y animales. Más específicamente, se centraron en dos características importantes de la proteína espiga: el dominio de unión al receptor (RBD), un tipo de gancho de agarre que se adhiere a las células huésped, y el sitio de escisión, un abridor de latas molecular que permite que el virus abra e ingrese en las células anfitrionas. Los científicos descubrieron que la porción RBD de las proteínas de la punta del SARS-CoV-2 había evolucionado para enfocarse en una característica molecular que hay en el exterior de las células humanas llamada ACE2 (enzima convertidora de angiotensina), un receptor involucrado en la regulación de la presión arterial. La proteína de la punta del SARS-CoV-2 es tan efectiva en la unión a las células humanas, de hecho, que los científicos concluyeron que era resultado de la selección natural y no producto de la ingeniería genética. Esta evidencia de evolución natural se respaldó por datos sobre la estructura molecular general del SARS-CoV-2. Si alguien buscara diseñar un nuevo coronavirus como patógeno, lo habrían construido a partir de la columna vertebral de un virus que se sabe que causa enfermedades. Pero los científicos descubrieron que el esqueleto del SARS-CoV-2 difería sustancialmente de los coronavirus ya conocidos y más bien se parecía a los virus relacionados que se pueden encontrar en los murciélagos y los pangolines. “Estas dos características del virus, las mutaciones en la porción RBD de la proteína espiga y su columna vertebral distinta, descartan la manipulación de laboratorio como un posible origen del SARS-CoV-2”, afirma Kristian Andersen. Por su parte, Josie Golding, responsable del departamento de Epidemiología de la Wellcome Trust de Londres, subraya que los hallazgos de Andersen y su equipo son “crucialmente importantes para aportar una visión basada en la evidencia de los rumores que han estado circulando sobre el origen no natural del virus (SARS-CoV-2) que causa Covid-19”. A partir de su análisis de secuenciación genómica, Andersen y su equipo analizaron los orígenes más probables para el SARS-CoV-2, siguiendo dos escenarios posibles. En el primero de los escenario, el virus habría evolucionado a su estado patógeno actual a través de la selección natural en un huésped no humano y luego habría saltado a las personas. Así es como habrían aparecido brotes previos de coronavirus en humanos al contraer el virus después de la exposición directa a civetas (SARS) y camellos (MERS).

Los investigadores propusieron a los murciélagos como el reservorio más probable para el SARS-CoV-2, ya que es muy similar a un coronavirus de murciélago. Sin embargo, no hay casos documentados de transmisión directa murciélago-persona, lo que sugiere que, probablemente, pudo haber un huésped intermedio entre murciélagos y humanos. En este escenario, las dos características distintivas de la proteína espiga del SARS-CoV-2, la porción RBD que se une a las células y el lugar de la escisión que abre el virus, habrían evolucionado a su estado actual antes de infectar a personas. En este caso, la epidemia actual probablemente surgiría rápidamente tan pronto como los humanos se infectaran, ya que el virus ya habría desarrollado las características que lo hacen patógeno y capaz de propagarse entre personas. En el otro escenario propuesto, una versión no patógena del virus habría saltado de un huésped animal a humanos y, luego, evolucionado a su estado patógeno actual dentro de la población humana. Por ejemplo, algunos coronavirus de pangolines, mamíferos tipo armadillo que se encuentran en Asia y África, tienen una estructura RBD muy similar a la del SARS-CoV-2. Un coronavirus de un pangolín podría haberse transmitido a un humano, ya sea directamente o a través de un huésped intermedio, como civetas o hurones. Entonces y como explican los investigadores, la otra característica de la proteína de espiga, el lugar de escisión, podría haber evolucionado dentro de un huésped humano, posiblemente a través de una circulación limitada no detectada en la población humana antes del comienzo de la epidemia.

Encontraron que el sitio de escisión del SARS-CoV-2 parece similar a los de cepas de gripe aviar que se ha demostrado que se transmite fácilmente entre personas. El SARS-CoV-2 podría haber desarrollado un lugar de escisión igual de virulento en células humanas y acelerar el inicio de la epidemia actual, ya que el coronavirus posiblemente se habría vuelto mucho más capaz de propagarse entre personas. El coautor del estudio, Andrew Rambaut, advierte que es difícil, si no imposible, saber en este momento cuál de los escenarios es más probable. Si el SARS-CoV-2 llegó a los humanos en su forma patógena actual de una fuente animal, aumenta la probabilidad de brotes futuros, ya que la cepa del virus que causa la enfermedad aún podría estar circulando entre la población animal y podría volver a saltar humanos. Las posibilidades de que un coronavirus no patógeno pase a la población humana y luego desarrolle propiedades similares al SARS-CoV-2 son menores. En cualquier caso, todo indica que el COVID-19 es producto de la evolución natural, con lo que se pone fin a cualquier especulación sobre su origen a través de ingeniería genética. La propagación de datos falsos y el desconocimiento de muchos, hace posible que esas afirmaciones calen en sociedad y, lo que es peor, se difundan. En 1994, a propósito del sida, un científico estadounidense de renombre aseguraba a quien le quería escuchar que el virus de la inmunodeficiencia humana no era el causante del sida. La situación se zanjó cuando el doctor Anthony Fauci, máximo responsable de los Institutos Nacionales de la Salud (INH) de EE UU, aceptó la invitación de una cadena de televisión para enfrentarse, dialécticamente hablando, con el autor del rumor. Con voz queda, el doctor Fauci, ante millones de espectadores, le dijo: “Si está tan seguro que el VIH no es el agente causante del sida, ¿por qué no se inocula usted mismo este retrovirus?”. El científico era Kary Mullis, recientemente fallecido, que consiguió el Nobel de Química por su hallazgo de la Reacción en Cadena de la Polimerasa (PCR).

Asimismo, antes de seguir con aplicaciones médicas de los algoritmos de IA, veamos algunos conceptos sobre Inteligencia Artificial. En los últimos años, los medios de comunicación han prestado una atención cada vez más grande a la inteligencia artificial (IA). El Aprendizaje Automático (Machine Learning) y el Aprendizaje Profundo (Deep Learning), ambos relacionados con la IA, han sido mencionados en numerosos artículos. Se nos promete un futuro de coches autónomos y asistentes digitales, un futuro algunas veces pintado con tintes pesimistas y otras veces de manera utópica, en donde el trabajo será escaso y la mayoría de la actividad económica será manejada por robots, computadoras y algoritmos de IA. Una pregunta que nos podemos hacer es si un computador con algoritmos de IA puede aprender por sí mismo como realizar una tarea específica, en vez de programadores especificando regla por regla como procesar los datos. ¿Podría un computador con algoritmos de IA aprender automáticamente estas reglas directamente de los datos a los que tiene acceso? A diferencia del clásico paradigma de la IA simbólica, donde seres humanos escriben las reglas, en forma de programa, y datos para ser procesados de acuerdo con dichas reglas, para así obtener respuestas o resultados de salida, con el Aprendizaje Automático los seres humanos pasamos los datos y las posibles respuestas, como ejemplos o casos, a partir de dichos datos como entrada, con el fin de obtener a la salida las reglas que nos permiten hacer el mapeo efectivo entre las entradas y sus correspondientes salidas. Estas reglas pueden ser luego aplicadas a nuevos datos para producir respuestas originales, es decir, generadas automáticamente por las reglas que el sistema “aprendió” y no por reglas explícitamente codificadas por programadores. Un sistema de Aprendizaje Automático es “entrenado” en vez de ser explícitamente “programado”. A este sistema se le presentan muchos ejemplos relevantes para la tarea en cuestión y este encuentra la estructura estadística o los patrones en dichos ejemplos, que eventualmente permiten al sistema aprender las reglas para automatizar dicha tarea. Por ejemplo, si deseamos automatizar la tarea del etiquetado de nuestras fotos de vacaciones, lo que haríamos es pasar al sistema de Aprendizaje Automático muchos ejemplos de fotos ya etiquetadas por humanos y el sistema aprendería las reglas estadísticas que le permitirían asociar fotos específicas con sus respectivas etiquetas.

Sin embargo, aunque el Aprendizaje Automático empezó a ser tenido en cuenta desde la década de1990, ahora se ha convertido en el más popular y exitoso de los sub-campos de la IA, una tendencia favorecida por la disponibilidad de mejor hardware y bases de datos gigantescas. El Aprendizaje Automático está fuertemente relacionado a la estadística matemática, pero con ciertas diferencias. A diferencia de la estadística, el Aprendizaje Automático tiende a lidiar con grandes y complejos conjuntos de datos, los cuales pueden contener millones de imágenes, cada una de ellas con miles de pixeles, para lo cual el clásico análisis estadístico, como el análisis bayesiano, sería inútil. Como resultado, el Aprendizaje Automático, y en especial el Aprendizaje Profundo, muestra poca teoría matemática, comparada con el campo de la estadística, y son considerados más como campos orientados hacia la ingeniería. Es decir, el Aprendizaje Automático es una disciplina aplicada, en la cual las ideas son probadas mucho más a menudo de forma empírica que de forma teórica. Para definir el Aprendizaje Profundo y entender la diferencia entre éste y otros enfoques del Aprendizaje Automático, primero necesitamos alguna idea de lo que hacen y cómo funcionan los algoritmos de Aprendizaje Automático. Acabamos de decir que el Aprendizaje Automático descubre reglas para ejecutar tareas de procesamiento de datos, dados los ejemplos de lo que se espera como respuesta o salida de dichos datos. Por lo tanto para realizar Aprendizaje Automático necesitaremos de tres ingredientes fundamentales: 1) Datos de entrada: Por ejemplo, si la tarea es reconocimiento de voz, estos datos de entrada serían archivos de sonido o grabaciones de gente hablando. Si la tarea es etiquetado de imágenes, estos datos podrían ser fotos o imágenes. 2) Ejemplos de lo que se espera como salida: En la tarea de reconocimiento de voz, estos podrían ser transcripciones generadas por humanos a partir de los archivos de audio. En la tarea de etiquetado de imágenes, las salidas esperadas pueden ser etiquetas tales como “oso”, “ratón”, “ser humano”, etc. 3) Una forma de medir si el algoritmo está realizando un buen trabajo: Este paso es necesario para determinar la distancia o desvío entre la salida actual generada por el algoritmo y la salida esperada. Esta medida es usada como señal de realimentación para ajustar la forma en la que el algoritmo trabaja y se actualiza. Este paso del ajustamiento es lo que llamamos propiamente “aprendizaje”. Estos elementos por si mismos son los fundamentales para todo tipo de algoritmo de Aprendizaje Automático y Aprendizaje Profundo. En el Aprendizaje Profundo, esta representaciones por capas son casi siempre aprendidas mediante modelos llamados Redes Neuronales, los cuales están literalmente estructurados en capas apiladas una después de la otra. El termino Redes Neuronales es una referencia a la neurobiología, pero, aunque algunos de los conceptos centrales en el Aprendizaje Profundo fueron desarrollados en parte de la inspiración tomada de nuestro entendimiento del cerebro, los modelos de Aprendizaje Profundo no son modelos del cerebro. No hay ninguna evidencia de que el cerebro implemente algunos de los mecanismos de aprendizaje usados en los modelos modernos de Aprendizaje Profundo.

A partir de lo indicado veremos ahora que es lo que realmente hace un algoritmo de Aprendizaje Automático y Aprendizaje Profundo para producir resultados que parecen salidos de la ciencia-ficción. Un modelo de Aprendizaje Automático transforma sus datos de entrada en respuestas con significado, un proceso que es “aprendido” de la exposición de dicho modelo a ejemplos previamente conocidos de entradas y salidas correspondientes. Por lo tanto, el problema central en el Aprendizaje Automático y el Aprendizaje Profundo es aprender representaciones útiles a partir de los datos de entrada, representaciones que nos acerquen a la generación o a la predicción de las salida esperadas. Pero, ¿qué es una representación? En su núcleo, una representación es una forma diferente de ver los datos, una forma diferente de representar o codificar los datos. Por ejemplo, una imagen a color puede ser codificada en formato RGB (red-green-blue) o en formato HSV (hue-saturation-value): Estas son dos representaciones diferentes de los mismos datos. Algunas tareas que pueden ser más difíciles utilizando una de esas representaciones pueden volverse mucho más fáciles al utilizar la otra representación. Por ejemplo, la tarea “seleccionar todos los pixeles rojos en una imagen” es mucho más simple en el formato RGB mientras que la tarea “hacer la imagen menos saturada” es más simple en el formato HSV. Los modelos de Aprendizaje Automático están diseñados para encontrar las representaciones más apropiadas a partir de la información que reciben como entrada, a partir de transformaciones de los datos que los hacen adecuados para la tarea en cuestión, así como en la tarea de clasificación de imágenes.

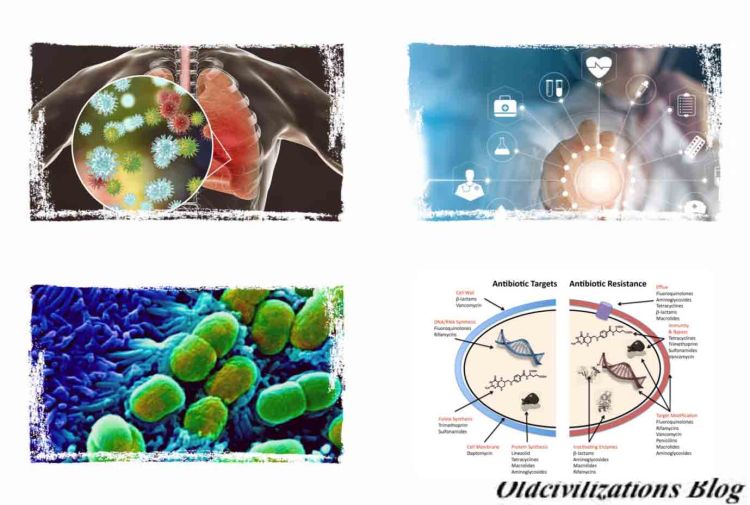

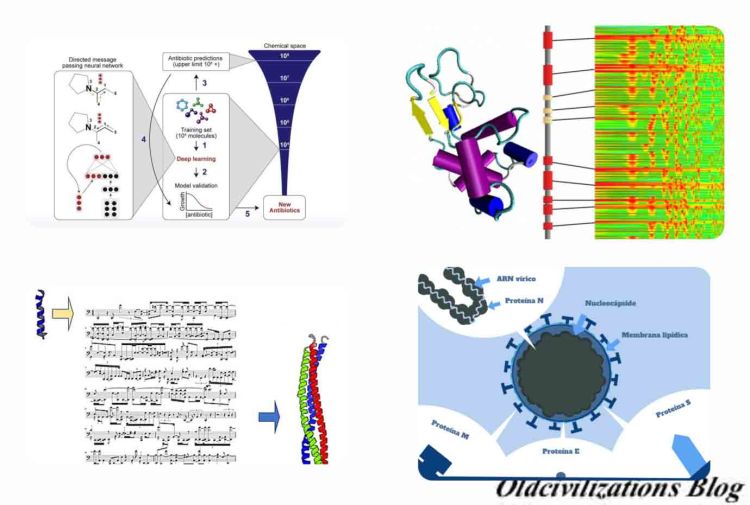

Y ahora entramos en el tema de la utilización de algoritmos de IA para combatir bacterias y virus, entre otros tipos de enfermedades. Según Steve Hanley, en un artículo del 22 de febrero de 2020, se está desarrollando un algoritmo de inteligencia artificial que crea antibióticos efectivos contra bacterias que se han vuelto resistentes a los antibióticos actuales. Pero esta experiencia puede servir para utilizar la IA para encontrar fármacos contra los virus, como el actual Covid-19, contra los que no sirven los actuales antibióticos. Sabemos que Alexander Fleming descubrió la penicilina por primera vez en 1928. Aunque su trabajo se basó en los esfuerzos de varios investigadores que lo precedieron, finalmente recibió el Premio Nobel de Medicina. En su discurso de aceptación, advirtió que las bacterias algún día podrían adaptarse a la penicilina y volverla menos útil, y eso es exactamente lo que sucedió. Hoy en día, hay muchas bacterias resistentes a los medicamentos que ignoran el efecto paliativo de la penicilina y muchos otros antibióticos que los médicos han recetado ampliamente, a menudo empujados por las compañías farmacéuticas. Crear nuevos medicamentos es un proceso complejo que puede ser extremadamente lento. Puede llevar años o a veces décadas desarrollar nuevos medicamentos, que es una de las razones por las que los precios de los medicamentos suelen ser extremadamente altos. Alguien tiene que pagar por todos los laboratorios y técnicos que llevan a cabo investigaciones sobre nuevos medicamentos año tras año. Muchas veces, los médicos ni siquiera saben si los medicamentos en los que están trabajando son efectivos hasta que están muy avanzados en su investigación. Los investigadores del MIT utilizaron un algoritmo de aprendizaje automático para identificar un medicamento basado en una molécula llamada HALicina, que mata muchas cepas de bacterias. La HALicina previno el desarrollo de resistencia a los antibióticos en la bacteria Escherichia coli (E.coli), una bacteria miembro de la familia de las enterobacterias y que forma parte de la microbiota del tracto gastrointestinal de animales homeotermos, como por ejemplo el ser humano. En cambio, la ciprofloxacina, un antibiótico del grupo de las fluoroquinolonas con efectos bactericidas, no lo hizo. Se vio que la inteligencia artificial puede ayudar a reducir drásticamente el tiempo que lleva descubrir nuevas drogas. Investigadores del MIT dicen que utilizando un algoritmo de IA han identificado un nuevo antibiótico que mata muchas bacterias resistentes a los medicamentos, según un informe de Science Daily. También resultó efectivo en dos ensayos con ratones infectados. Lo que hace que este descubrimiento sea aún más notable es que una computadora con este algoritmo de IA pudo realizar la tarea en solo tres días.

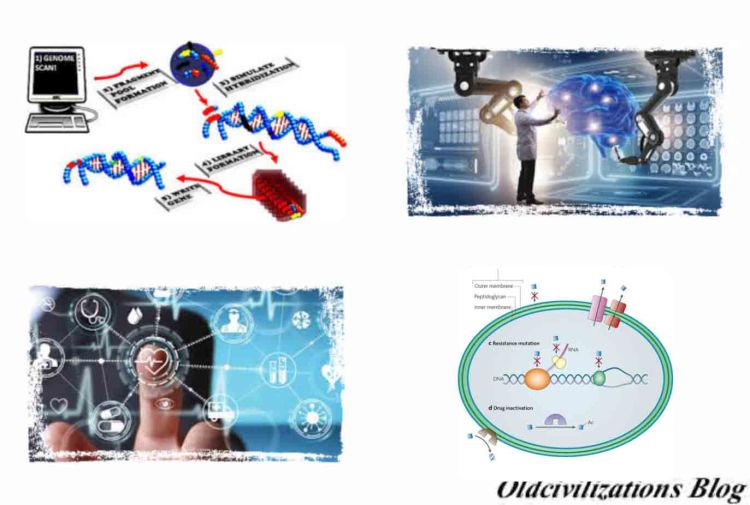

El algoritmo de IA está diseñado para identificar antibióticos potenciales que matan bacterias usando diferentes mecanismos y estrategias que los utilizados por las drogas existentes, según MIT News. Según James Collins, profesor de ingeniería médica y ciencia: “Queríamos desarrollar una plataforma que nos permitiera aprovechar el poder de la inteligencia artificial para marcar el comienzo de una nueva era de descubrimiento de antibiótico. Nuestro enfoque reveló esta increíble molécula que posiblemente sea uno de los antibióticos más potentes que se ha descubierto. Nos enfrentamos a una crisis creciente en torno a la resistencia a los antibióticos, y esta situación está siendo generada por un número cada vez mayor de agentes patógenos que se vuelven resistentes a los antibióticos existentes y una tubería anémica en las industrias biotecnológica y farmacéutica de nuevos antibióticos“. El algoritmo también identificó varios otros antibióticos potenciales que ahora se someterán a más pruebas. “El modelo de aprendizaje automático puede explorar grandes espacios químicos que pueden ser prohibitivamente costosos para los enfoques experimentales tradicionales“, dice Regina Barzilay, profesora de ingeniería eléctrica y ciencias de la computación en el MIT. Hasta ahora, el modelado por computadora era demasiado impreciso para producir resultados útiles, pero las redes neuronales más recientes pueden aprender automáticamente cómo lograr potenciales antibióticos utilizando la potencia de computadoras. Los investigadores diseñaron su nuevo modelo para buscar características químicas que hagan que las moléculas sean efectivas para matar la bacteria E.coli. Entrenaron el modelo con alrededor de 2.500 moléculas, incluidos alrededor de 1.700 medicamentos aprobados por la U.S. Food and Drug Administration (FDA) y un conjunto de 800 productos naturales con diversas estructuras y una amplia gama de actividades biológicas. Una vez que el modelo fue entrenado, los investigadores lo probaron en aproximadamente 6,000 compuestos. El modelo seleccionó una molécula que se predijo que tenía una fuerte actividad antibacteriana y tenía una estructura química diferente de cualquier antibiótico existente. Esa molécula se ha llamado HALicina, un nombre derivado de HAL, la computadora que aparece en la película de Stanley Kubrick: 2001 una odisea del espacio. Se cree que Kubrick eligió HAL porque todas las letras preceden a las iniciales IBM, que era el nombre de la compañía de computadoras dominante en el mundo en el momento de la película. Los investigadores lo probaron contra docenas de cepas bacterianas aisladas de pacientes y cultivadas en laboratorio y descubrieron que era capaz de matar a muchas que son resistentes al tratamiento antibiótico actual, incluidos Clostridium difficile, Acinetobacter baumannii y Mycobacterium tuberculosis.

El medicamento funcionó contra todas las especies de bacterias que probaron, con la excepción de Pseudomonas aeruginosa, un patógeno pulmonar difícil de tratar. MIT News añade que la HALicina puede matar bacterias al alterar su capacidad de producir ATP, una molécula que las células usan para almacenar energía. Los investigadores creen que las células tendrán dificultades para adaptarse a un proceso tan disruptivo. “Cuando se trata de una molécula que probablemente se asocia con componentes de membrana, una célula no puede adquirir necesariamente una sola mutación o un par de mutaciones para cambiar la química de la membrana externa. Mutaciones como esa tienden a ser mucho más complejas de adquirir evolutivamente”, dice Stokes. Después de identificar la HALicina, los investigadores utilizaron su modelo para examinar más de 100 millones de moléculas seleccionadas de la base de datos ZINC15, una colección en línea de aproximadamente 1.500 millones de compuestos químicos. La base de datos ZINC contiene una colección de compuestos químicos disponibles en el mercado preparados especialmente para la detección virtual . ZINC es utilizado por investigadores, como biólogos o químicos, por compañías farmacéuticas , compañías de biotecnología y universidades de investigación. Este examen, que tardó solo tres días, identificó 23 candidatos que eran estructuralmente diferentes de los antibióticos existentes y que se pronostica que no son tóxicos para las células humanas. En pruebas de laboratorio contra cinco especies de bacterias, los investigadores encontraron que ocho de las moléculas mostraban actividad antibacteriana, y dos eran particularmente poderosas. Los investigadores ahora planean probar estas moléculas más, y también para examinar más de la base de datos ZINC15. Los investigadores también planean usar su modelo para diseñar nuevos antibióticos y optimizar las moléculas existentes. Por ejemplo, podrían entrenar al modelo para agregar características que harían que un antibiótico en particular atacara solo ciertas bacterias, evitando que mate bacterias beneficiosas en el tracto digestivo de un paciente. Entonces, los científicos de hoy pueden hacer en tres días lo que normalmente lleva meses, años o incluso décadas para lograrlo. ¡Imagínense si ese tipo de poder de investigación puede aplicarse a la búsqueda de antídotos para todo tipo de virus y enfermedades!

Los antibióticos funcionan a través de una variedad de mecanismos, como el bloqueo de las enzimas involucradas en la biosíntesis de la pared celular, la reparación del ADN o la síntesis de proteínas. Pero la estrategia que sigue la HALicina no es convencional, ya que interrumpe el flujo de protones a través de la membrana celular. Los protones son partículas subatómicas con una carga eléctrica elemental positiva, que forma parte del núcleo del átomo, y cuya carga es igual en valor absoluto y de signo contrario a la del electrón, así como una masa 1836 veces superior a la de un electrón. En las pruebas iniciales con animales, la HALicina también parecía tener baja toxicidad y ser robusta contra la resistencia de las bacterias. Según Collins: “En los experimentos habituales, la resistencia a otros compuestos antibióticos generalmente surge dentro de un día o dos. Pero incluso después de 30 días de tales pruebas, no vimos ninguna resistencia contra la HALicina“. Luego, el algoritmo de IA examinó más de 107 millones de estructuras moleculares en una base de datos llamada ZINC15. De una lista de 23, las pruebas físicas identificaron 8 con actividad antibacteriana. Dos de estos tenían una potente actividad contra una amplia gama de patógenos y podían vencer incluso a cepas de E. coli resistentes a los antibióticos. El estudio es “un gran ejemplo del creciente cuerpo de trabajo que utiliza métodos computacionales para descubrir y predecir propiedades de posibles drogas“, dice Bob Murphy, biólogo computacional de la Universidad Carnegie Mellon en Pittsburgh. Señala que los métodos de IA se han desarrollado previamente para extraer grandes bases de datos de genes y metabolitos, cualquier molécula utilizada, capaz o producida durante el metabolismo, para identificar tipos de moléculas que podrían incluir nuevos antibióticos. Pero Collins y su equipo dicen que su enfoque es diferente: en lugar de buscar estructuras específicas o clases moleculares, están entrenando a su algoritmo de IA para buscar moléculas con una actividad particular. El equipo ahora espera asociarse con un grupo o compañía externa para incorporar la HALicina a los ensayos clínicos. También quiere ampliar el enfoque para encontrar más antibióticos nuevos y diseñar moléculas desde cero. Barzilay dice que su último trabajo es una prueba de concepto. “Este estudio lo reúne todo y demuestra lo que se puede hacer“.

Empezamos con una interesante entrevista que Kim Martineau, de MIT Quest for Intelligence, efectuó el 2 de abril de 2020 a Markus Buehler, músico y profesor del Instituto Tecnológico de Massachusetts (MIT). En esta entrevista se pregunta a Markus Buehler sobre la configuración del coronavirus SARS-CoV-2 (COVID-19) y las proteínas inspiradas en la IA para la música. Traducido al sonido, el SARS-CoV-2 (COVID-19) engaña a nuestro oído de la misma manera que el virus engaña a nuestras células. En la entrevista dice que las proteínas que componen todos los seres vivos son sensibles a la música. Pero, ¿qué son las proteínas? Las proteínas son moléculas formadas por aminoácidos que están unidos por un tipo de enlaces conocidos como enlaces peptídicos, un enlace químico que se establece entre el grupo carboxilo de un aminoácido y el grupo amino de otro aminoácido. El orden y la disposición de los aminoácidos dependen del código genético de cada persona. Todas las proteínas están compuestas por carbono, hidrógeno, oxígeno, nitrógeno, aunque la mayoría de proteínas contienen también azufre y fósforo. Las proteínas suponen aproximadamente la mitad del peso de los tejidos del organismo y están presentes en todas las células del cuerpo, además de intervenir en prácticamente todos los procesos biológicos que se producen. De entre todas las bio-moléculas, las proteínas desempeñan un papel fundamental en el organismo. Son esenciales para el crecimiento, gracias a su contenido de nitrógeno, que no está presente en otras moléculas como grasas o hidratos de carbono. También lo son para las síntesis y mantenimiento de diversos tejidos o componentes del cuerpo, como los jugos gástricos, la hemoglobina, las vitaminas, las hormonas y las enzimas, que actúan como catalizadores biológicos haciendo que aumente la velocidad a la que se producen las reacciones químicas del metabolismo. Asimismo, ayudan a transportar determinados gases a través de la sangre, como el oxígeno y el dióxido de carbono, y funcionan a modo de amortiguadores para mantener el equilibrio ácido-base y la presión oncótica del plasma, o presión osmótica coloidal, que es la presión osmótica debida a las grandes moléculas que se encuentran en disolución o suspensión coloidal. En el plasma sanguíneo la presión oncótica es ejercida principalmente por proteínas y complejos proteicos, sobre todo albúmina, y es una fuerza que tiende a empujar agua hacia el interior de los vasos sanguíneos o previene su salida, en oposición a la presión hidrostática que empuja el agua, y también solutos, hacia el exterior.

Otras funciones más específicas de las proteínas son, por ejemplo, las de los anticuerpos, un tipo de proteínas que actúan como defensa natural frente a posibles infecciones o agentes externos, además del colágeno, cuya función de resistencia lo hace imprescindible en los tejidos de sostén, y la miosina y la actina, dos proteínas musculares que hacen posible el movimiento, entre muchas otras. Las propiedades principales de las proteínas, que permiten su existencia y el correcto desempeño de sus funciones son la estabilidad y la solubilidad. La estabilidad hace referencia a que las proteínas deben ser estables en el medio en el que estén almacenadas o en el que desarrollan su función, de manera que su vida media sea lo más larga posible y no genere contratiempos en el organismo. En cuanto a la solubilidad, se refiere a que cada proteína tiene una temperatura y un pH que se deben mantener para que los enlaces sean estables. Las proteínas tienen también algunas otras propiedades secundarias, que dependen de las características químicas que poseen. Es el caso de la especificidad, en que su estructura hace que cada proteína desempeñe una función específica y concreta diferente de las demás y de la función que pueden tener otras moléculas. También la amortiguación de pH, ya que las proteínas pueden comportarse como ácidos o como bases, en función de si pierden o ganan electrones, y hacen que el pH de un tejido o compuesto del organismo se mantenga a los niveles adecuados. Asimismo, además tienen la capacidad electrolítica que les permite trasladarse de los polos positivos a los negativos y viceversa. Las proteínas son susceptibles de ser clasificadas en función de su forma y en función de su composición química. Según su forma, existen proteínas fibrosas, alargadas e insolubles en agua, como la queratina, el colágeno y la fibrina, así como las globulares, de forma esférica y compacta, y solubles en agua. Este es el caso de la mayoría de enzimas y anticuerpos, así como de ciertas hormonas. También existen las mixtas, con una parte fibrilar y otra parte globular. Dependiendo de la composición química que posean hay proteínas simples y proteínas conjugadas, también conocidas como heteroproteínas. Las simples se dividen a su vez en escleroproteínas y esferoproteínas. Las proteínas son esenciales en la dieta. Los aminoácidos que las forman pueden ser esenciales o no esenciales. En el caso de los primeros, no los puede producir el cuerpo por sí mismo, por lo que tienen que adquirirse a través de la alimentación. Son especialmente necesarias en personas que se encuentran en edad de crecimiento, como niños y adolescentes, y también en mujeres embarazadas, ya que hacen posible la producción de células nuevas. Están presentes sobre todo en los alimentos de origen animal como la carne, el pescado, los huevos y la leche. Pero también lo están en alimentos vegetales, como la soja, las legumbres y los cereales, aunque en menor proporción. Su ingesta aporta al organismo 4 kilocalorías por cada gramo de proteína.

Volviendo a Markus Buehler, vemos que desarrolla modelos de inteligencia artificial (IA) para diseñar nuevas proteínas, a veces traduciéndolas a un determinado sonido. Su objetivo es crear nuevos materiales biológicos para aplicaciones sostenibles y no tóxicas. En un proyecto con el MIT-IBM Watson AI Lab, Buehler está buscando una proteína para extender la vida útil de los alimentos perecederos. En un nuevo estudio en Extreme Mechanics Letters, él y sus colaboradores ofrecen un candidato prometedor. Se trata de una proteína de la seda hecha por abejas para su uso en la construcción de colmenas. En otro estudio reciente, en APL Bioengineering, fue un paso más allá y utilizó la IA para descubrir una proteína completamente nueva. Cuando ambos estudios se publcaron, el brote de Covid-19 estaba surgiendo en los Estados Unidos, y Buehler dirigió su atención a la proteína espiga del SARS-CoV-2, el apéndice que hace que el nuevo coronavirus sea tan contagioso. Él y sus colegas están tratando de obtener sus propiedades vibratorias a través de espectros de sonido basados en moléculas, que podrían ser clave para detener el virus. Pregunta: Su trabajo se centra en las proteínas hélice alfa que se encuentran en la piel y el cabello. ¿Por qué hace esta proteína tan intrigante? Debemos aclarar que las hélice alfa son estructuras secundarias de las proteínas. Esta hélice mantiene su forma por la presencia de los puentes de hidrógeno que se forman entre los átomos de oxígeno del grupo carbonilo de un aminoácido y el átomo de hidrógeno del grupo amino de otro aminoácido situado a cuatro aminoácidos de distancia en la cadena. En las proteínas, la hélice alfa es el principal motivo de estructura secundaria. Fue postulada primero por Linus Pauling, Robert Corey, y Herman Branson en 1951 basándose en las estructuras cristalográficas entonces conocidas de aminoácidos y péptidos. Respuesta: Las proteínas son los ladrillos y el mortero que forman nuestras células, órganos y cuerpo. Las proteínas hélice alfa son especialmente importantes. Su estructura tipo resorte les da elasticidad y resistencia, por lo que la piel, el cabello, las plumas, los cascos e incluso las membranas celulares son tan duraderas. Pero no solo son resistentes mecánicamente, sino que también tienen propiedades antimicrobianas incorporadas. Con IBM, estamos tratando de aprovechar este rasgo bioquímico para crear un recubrimiento de proteínas que pueda frenar el deterioro de los alimentos que se pudren rápidamente, como las fresas.

Pregunta: ¿Cómo escogieron la AI para producir esta proteína de seda? Respuesta: Capacitamos un modelo de aprendizaje profundo en el banco de datos de proteínas, que contiene las secuencias de aminoácidos y las formas tridimensionales de aproximadamente 120.000 proteínas. Luego alimentamos al modelo con un fragmento de una cadena de aminoácidos para la seda de abeja y le pedimos que predijera la forma de la proteína, átomo por átomo. Validamos nuestro trabajo sintetizando la proteína por primera vez en un laboratorio, un primer paso para desarrollar un recubrimiento antimicrobiano y estructuralmente duradero, que se pueda aplicar a los alimentos. Mi colega, Benedetto Marelli, se especializa en esta parte del proceso. También utilizamos la plataforma para predecir la estructura de las proteínas que aún no existen en la naturaleza. Así es como diseñamos nuestra proteína completamente nueva en el estudio APL Bioengineering. Pregunta: ¿Cómo mejora su modelo con otros métodos de predicción de proteínas? Respuesta: Utilizamos predicción de extremo a extremo. El modelo construye la estructura de la proteína directamente a partir de su secuencia, traduciendo patrones de aminoácidos en geometrías tridimensionales. Es como traducir un conjunto de instrucciones de IKEA en una estantería construida, menos la frustración. A través de este enfoque, el modelo aprende efectivamente cómo construir una proteína a partir de la proteína en sí, a través del lenguaje de sus aminoácidos. Sorprendentemente, nuestro método puede predecir con precisión la estructura de la proteína sin una plantilla. Supera a otros métodos de plegado y es significativamente más rápido que el modelado basado en la física. Debido a que el banco de datos de proteínas se limita a las proteínas que se encuentran en la naturaleza, necesitábamos una forma de visualizar nuevas estructuras para producir nuevas proteínas desde cero. Pregunta: ¿Cómo podría usarse el modelo para diseñar una proteína real? Respuesta: Podemos construir modelos átomo por átomo para secuencias encontradas en la naturaleza que aún no se han estudiado, como lo hicimos en el estudio de APL Bioingeniería, utilizando un método diferente. Podemos visualizar la estructura de la proteína y usar otros métodos computacionales para evaluar su función, analizando su estabilidad y las otras proteínas a las que se une en las células. Nuestro modelo podría usarse en el diseño de medicamentos o para interferir con las vías bioquímicas mediadas por proteínas en las enfermedades infecciosas.

Pregunta: ¿Cuál es el beneficio de traducir proteínas en sonido? Respuesta: Nuestros cerebros son excelentes para procesar sonidos. En un barrido, nuestros oídos captan todas sus características: tono, timbre, volumen, melodía, ritmo y acordes. Necesitaríamos un microscopio de alta potencia para ver un detalle equivalente en una imagen, y nunca podríamos verlo todo de una vez. El sonido es una forma muy elegante de acceder a la información almacenada en una proteína. Por lo general, el sonido se consigue haciendo vibrar un material, como una cuerda de guitarra, mientras que la música se hace al organizar los sonidos en determinados patrones. Con AI podemos combinar estos conceptos y usar vibraciones moleculares y redes neuronales para construir nuevas formas musicales. Hemos estado trabajando en métodos para convertir las estructuras de proteínas en representaciones audibles, y traducir estas representaciones en nuevos materiales. Pregunta: ¿Qué nos puede decir sobre convertir en sonidos la proteína espiga del SARS-CoV-2? Respuesta: Su pico de proteínas contiene tres cadenas de proteínas dobladas en un patrón misterioso. Estas estructuras son demasiado pequeñas para que el ojo humano las vea, pero se pueden escuchar. Representamos la estructura de la proteína física, con sus cadenas entrelazadas, como melodías entrelazadas que forman una composición en varias capas. Se pueden representar la secuencia de aminoácidos de la proteína espiga, sus patrones de estructura secundaria y sus intrincados pliegues tridimensionales. La pieza resultante es una forma de música de contrapunto, una técnica de improvisación y composición musical que evalúa la relación existente entre dos o más voces independientes (polifonía) con la finalidad de obtener cierto equilibrio armónico. Como una sinfonía, los patrones musicales reflejan la geometría de intersección de la proteína realizada al materializar su código ADN. Pregunta: ¿Qué aprendiste? Respuesta: El virus tiene una extraña habilidad para engañar y explotar al huésped para su propia multiplicación. Su genoma secuestra la maquinaria de fabricación de proteínas de la célula huésped y la obliga a replicar el genoma viral y producir proteínas virales para generar nuevos virus. Mientras se escucha, uno puede sorprenderse por el tono agradable e incluso relajante de la música. Pero engaña a nuestro oído de la misma manera que el virus engaña a nuestras células. Es un invasor disfrazado de visitante amigable. A través de la música, podemos ver el pico de SARS-CoV-2 desde un nuevo ángulo y apreciar la urgente necesidad de aprender el lenguaje de las proteínas.

Pregunta: ¿Puede abordarse con esta técnica el Covid-19 y el virus que lo causa? Respuesta: A largo plazo, sí. La traducción de proteínas en sonido les brinda a los científicos otra herramienta para comprender y diseñar proteínas. Incluso una pequeña mutación puede limitar o mejorar el poder patógeno del SARS-CoV-2. A través de la conversión en sonido también podemos comparar los procesos bioquímicos de su proteína espiga con coronavirus anteriores, como el SARS o el MERS. En la música que creamos, analizamos la estructura vibratoria de la proteína espiga que infecta al huésped. Comprender estos patrones vibratorios es fundamental para el diseño de medicamentos y otras acciones. Las vibraciones pueden cambiar a medida que las temperaturas aumentan, por ejemplo, y también pueden decirnos por qué la punta del SARS-CoV-2 gravita hacia las células humanas más que otros virus. Estamos explorando estas preguntas en investigaciones actuales y en curso con mis estudiantes graduados. También podríamos usar un enfoque compositivo para diseñar medicamentos para atacar el virus. Podríamos buscar una nueva proteína que coincida con la melodía y el ritmo de un anticuerpo capaz de unirse a la proteína espiga, lo que interfiere con su capacidad de infectar. Pregunta: ¿Cómo puede la música ayudar en el diseño de proteínas? Respuesta: Puedes pensar en la música como un reflejo algorítmico de la estructura. Las variaciones Goldberg, una composición musical para teclado, de Johann Sebastian Bach, por ejemplo, son una realización brillante del contrapunto, un principio que también hemos encontrado en las proteínas. Ahora podemos escuchar este concepto del contrapunto a medida que la naturaleza lo compuso en las proteínas, y compararlo con ideas en nuestra imaginación, o usar algoritmos de IA para hablar el lenguaje de diseño de las proteínas y dejar que imagine nuevas estructuras. Creemos que el análisis del sonido y la música puede ayudarnos a comprender mejor el mundo material. La expresión artística es, después de todo, solo un modelo del mundo dentro de nosotros y a nuestro alrededor.

Es importante aprender el lenguaje de las proteínas. Buehler explica que todo el concepto consiste en comprender mejor las proteínas y su amplia gama de variaciones. Las proteínas constituyen el material estructural de la piel, los huesos y los músculos, pero también son enzimas, señales químicas, interruptores moleculares y una gran cantidad de otros materiales funcionales que conforman la maquinaria de todos los seres vivos. Pero sus estructuras, incluida la forma en que se pliegan en las formas que a menudo determinan sus funciones, son extremadamente complicadas. Buehler explica que: “Tienen su propio idioma y no sabemos cómo funciona. No sabemos qué hace que una proteína de seda sea una proteína de seda o qué patrones reflejan las funciones que se encuentran en una enzima. No sabemos el código“. Al traducir ese lenguaje a una forma diferente a la que los humanos están particularmente en sintonía, y que permite que diferentes aspectos de la información se codifiquen en diferentes dimensiones, como tono, volumen y duración, Buehler y su equipo esperan obtener nuevas ideas sobre el relaciones y diferencias entre diferentes familias de proteínas y sus variaciones, y utilice estas ideas como una forma de explorar los muchos ajustes y modificaciones posibles de su estructura y función. Al igual que con la música, la estructura de las proteínas es jerárquica, con diferentes niveles de estructura en diferentes escalas de duración o tiempo. El nuevo método traduce una secuencia de aminoácidos de proteínas en una secuencia de sonidos de percusión y rítmicos. Luego, el equipo de Markus Buehler utilizó un sistema de inteligencia artificial para estudiar el catálogo de melodías producidas por una amplia variedad de proteínas diferentes. Hicieron que el sistema de IA introdujera ligeros cambios en la secuencia musical o creara secuencias completamente nuevas, y luego tradujera los sonidos nuevamente en proteínas que correspondían a las versiones modificadas o de nuevo diseño. Con este proceso, pudieron crear variaciones de las proteínas existentes como, por ejemplo, una que se encuentra en la seda de araña, uno de los materiales más fuertes de la naturaleza, haciendo así nuevas proteínas a diferencia de las producidas por la evolución natural. Los sonidos de percusión y rítmicos que se escuchan aquí se generan completamente a partir de secuencias de aminoácidos.

Aunque los propios investigadores pueden no conocer las reglas subyacentes, “la IA ha aprendido el lenguaje de cómo se diseñan las proteínas y puede codificarla para crear variaciones de versiones existentes o diseños de proteínas completamente nuevos“, dice Buehler. Dado que hay billones de combinaciones potenciales, cuando se trata de crear nuevas proteínas “no podrías hacerlo desde cero, pero eso es lo que la IA puede hacer“. Es un proceso de composición de nuevas proteínas. Al usar dicho sistema, entrenar el sistema de IA con un conjunto de datos para una clase particular de proteínas, puede llevar algunos días, pero luego puede producir en microsegundos un diseño para una nueva variante. Según Buehler: “Ningún otro método se acerca. La desventaja es que el modelo no nos dice qué está pasando realmente dentro. Simplemente sabemos que funciona“. Esta forma de codificar la estructura de proteínas en la música refleja una realidad más profunda. Buehler nos dice que: “Cuando miras una molécula en un libro de texto, es estática. Pero no es estático en absoluto. Se mueve y vibra. Cada parte de la materia es un conjunto de vibraciones. Y podemos usar este concepto como una forma de describir la materia“. El método aún no permite ningún tipo de modificaciones dirigidas a cualquier cambio en las propiedades, como la resistencia mecánica, la elasticidad o la reactividad química, sino que será esencialmente aleatorio. Buehler dice que: “Todavía tienes que hacer el experimento. Cuando se produce una nueva variante de proteína, no hay forma de predecir lo que hará“. El equipo también creó composiciones musicales desarrolladas a partir de los sonidos de aminoácidos, que definen esta nueva escala musical de 20 tonos. Las piezas de arte que construyeron consisten completamente en los sonidos generados a partir de aminoácidos. Buehler añade: “No se utilizan instrumentos sintéticos o naturales, lo que muestra cómo esta nueva fuente de sonidos se puede utilizar como una plataforma creativa“. A lo largo de los ejemplos se usan motivos musicales derivados de proteínas existentes de forma natural y proteínas generadas por IA, y todos los sonidos, incluidos algunos que se asemejan a bajos o tambores, también se generan a partir de los sonidos de aminoácidos. Los investigadores han creado una aplicación gratuita para teléfonos inteligentes Android, llamada Amino Acid Synthesizer, para reproducir los sonidos de los aminoácidos y grabar secuencias de proteínas como composiciones musicales.

Marc Meyers, profesor de ciencia de materiales en el Universidad de California en San Diego, que no participó en este trabajo, nos dice: “Markus Buehler ha sido dotado con el alma más creativa, y sus exploraciones en el funcionamiento interno de las biomoléculas están avanzando en nuestra comprensión de la respuesta mecánica de los materiales biológicos de la manera más significativa“. Meyers agrega: “El enfoque de esta imaginación en la música es una dirección novedosa e intrigante. Esta es la música experimental en su mejor momento. Los ritmos de la vida, incluidas las pulsaciones de nuestro corazón, fueron las fuentes iniciales de sonidos repetitivos que engendraron el maravilloso mundo de la música. Markus ha descendido al nanoespacio para extraer los ritmos de los aminoácidos, los componentes básicos de la vida“. “Las secuencias de proteínas son complejas, como lo son las comparaciones entre secuencias de proteínas“, dice Anthony Weiss, profesor de bioquímica y biotecnología molecular en la Universidad de Sydney, Australia, que tampoco estaba relacionado con este trabajo. El equipo del MIT “proporciona un enfoque impresionante, entretenido e inusual para acceder e interpretar esta complejidad. El enfoque se beneficia de nuestra capacidad innata para escuchar patrones musicales complejos. A través de la armonía ahora tenemos una herramienta entretenida y útil para comparar y contrastar secuencias de aminoácidos“. El equipo también incluyó al científico investigador Zhao Qin y Francisco Martin-Martinez en el MIT. El trabajo fue apoyado por la Oficina de Investigación Naval de los EE. UU. Y los Institutos Nacionales de Salud.

Es realmente sorprendente la idea de traducir proteínas a música y viceversa. Al convertir las estructuras moleculares en sonidos, los investigadores obtienen información sobre las estructuras de proteínas y crean nuevas variaciones. David L. Chandler, de la Oficina de noticias del MIT plantea la siguiente pregunta: ¿Quiere crear un nuevo tipo de proteína que pueda tener propiedades útiles? Y la respuesta es que no hay problema ya que, en un sorprendente matrimonio de ciencia y arte, los investigadores del MIT han desarrollado un sistema para convertir las estructuras moleculares de las proteínas, los componentes básicos de todos los seres vivos, en un sonido audible que se asemeja a pasajes musicales. Luego, invirtiendo el proceso, pueden introducir algunas variaciones en la música y convertirla nuevamente en nuevas proteínas nunca antes vistas en la naturaleza. Aunque no es tan simple como tararear la música de una nueva proteína, el nuevo sistema se acerca. Proporciona una forma sistemática de traducir la secuencia de aminoácidos de una proteína en una secuencia musical, utilizando las propiedades físicas de las moléculas para determinar los sonidos. Aunque los sonidos se transponen con el fin de ponerlos dentro del rango audible para los humanos, los tonos y sus relaciones se basan en las frecuencias vibratorias reales de cada molécula de aminoácidos, calculadas utilizando teorías de la química cuántica. Tal como ya hemos indicado, el sistema fue desarrollado por Markus Buehler, junto con el doctor Chi Hua Yu y otros. Como se describe en la revista ACS Nano, el sistema traduce los 20 tipos de aminoácidos, los bloques de construcción que se unen en cadenas para formar todas las proteínas, en una escala de 20 tonos. La secuencia larga de aminoácidos de cualquier proteína se convierte en una secuencia de notas. Si bien esta escala no suena familiar para las personas acostumbradas a las tradiciones musicales occidentales, los oyentes pueden reconocer fácilmente las relaciones y diferencias después de familiarizarse con los sonidos. Buehler dice que después de escuchar las melodías resultantes, ahora es capaz de distinguir ciertas secuencias de aminoácidos que corresponden a proteínas con funciones estructurales específicas.